Руслан Салахутдинов

Фото: Орифжон Хошимов / Gazeta

«ИИ сможет развиваться самостоятельно». Главное из выступления вице-президента Meta Руслана Салахутдинова

Современный искусственный интеллект ещё далёк от человеческого мышления, но уже способен учиться без постоянного вмешательства. О перспективах такого развития, будущей роли ИИ и связанных с ним рисках на полях ICT Week рассказал вице-президент Meta по искусственному интеллекту Руслан Салахутдинов.

Сегодня, 19:15

Общество

Искусственный интеллект постепенно выходит за рамки систем, которым требуется постоянный контроль человека. Новые подходы в обучении позволяют моделям не только решать задачи, но и самостоятельно придумывать их, проверять результат и улучшать собственные навыки. О перспективах «саморазвивающихся систем» в рамках ICT Week 2025 рассказал вице-президент Meta по генеративному искусственному интеллекту Руслан Салахутдинов, передаёт корреспондент «Газеты».

Современные модели искусственного интеллекта всё ещё далеки от человеческого уровня мышления. Их слабые места — сложное планирование на длинных временных горизонтах и выполнение комплексных задач.

Важным направлением в развитии ИИ становятся синтетические данные. По словам учёного, собрать в интернете примеры того, как люди решают прикладные задачи, крайне сложно. Именно поэтому исследователи всё чаще обучают модели на сгенерированных примерах.

Реклама на Gazeta

«Синтетические данные становятся новым рубежом в масштабировании и обучении ИИ», — сказал Салахутдинов.

Он показал примеры, где модель самостоятельно придумывает задачу, пытается её решить, а затем проверяет правильность результата. Так системы учатся находить расписание работы заведений, анализировать отчёты или описывать функционал сайтов. Такой подход позволяет агенту постепенно переходить от простых заданий к более сложным, развивая собственные навыки.

Однако, отметил Салахутдинов, при работе с веб-сервисами есть риски. Если, к примеру, агент будет бесконечно «учиться» бронировать авиабилеты, это может повлиять на ценообразование: авиакомпании увидят много броней на конкретный рейс и повысят цены из-за повышенного спроса. Поэтому исследователи ограничивают эксперименты задачами, которые не меняют состояние интернета.

По оценкам учёного, до 89% задач, предложенных моделями самостоятельно, оказываются выполнимыми. Это открывает путь к созданию «самоулучшающихся систем», которые смогут непрерывно обучаться, не требуя постоянного контроля со стороны человека.

По его словам, ключевая задача в самообучении ИИ заключается не только в создании разнообразных тестов, но и оценке того, насколько успешно агент их выполняет. Для этого используют языковые модели: они выступают в роли «судей», анализируют последовательность действий и делают вывод, решена задача или нет.

«Так возникает цикл, где модель придумывает задание, выполняет его и затем сама же оценивает результат», — пояснил Салахутдинов.

По его данным, GPT-4 правильно определяет успешность выполнения в 82% случаев, хотя ошибки пока сохраняются.

Собранные таким образом данные позволяют улучшать сами модели. Исследования показали, что даже сравнительно небольшая модель Qwen после дообучения превзошла по ряду задач более крупные системы. В некоторых тестах её точность выросла на 45%.

«Мы видим, что маленькая модель может самообучаться и выходить на уровень современных передовых систем», — отметил учёный.

Следующий шаг — масштабирование. Исследователи планируют задействовать до 385 миллионов уникальных доменов, что может увеличить объём данных для обучения в тысячу раз. Кроме того, команда работает над системами «онлайн-обучения с подкреплением», когда модель не ждёт завершения цикла тренировки, а непрерывно генерирует новые задачи, решает их и накапливает опыт.

Как в будущем будут использовать ИИ

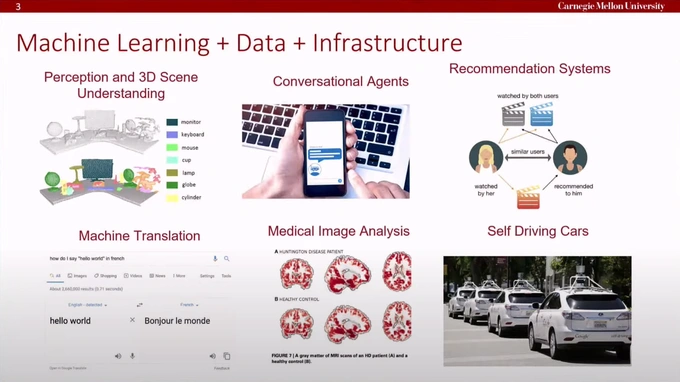

В своём докладе вице-президент Meta также рассказал о ключевых перспективах применения искусственного интеллекта. Среди сфер, где ИИ уже активно внедряется, он отметил медицинскую диагностику, рекомендательные системы, анализ изображений, беспилотный транспорт.

«Если вы хотите повлиять на будущее, обратите внимание на область защиты данных. Здесь я вижу колоссальные возможности для новых идей», — сказал он.

Применение ИИ.

Отдельное внимание докладчик уделил генеративным системам. По его словам, развитие больших языковых моделей и мультимодальных ИИ открывает новые возможности в создании изображений и видео, а также в области диалоговых агентов.

«Сегодня мы видим взрывной рост в генерации контента. И за этим стоят масштабные инвестиции: речь идёт о миллиардах долларов по всему миру», — отметил он.

Учёный обозначил главную задачу будущего. Это создание «агентных» систем, способных автономно действовать в реальной среде, воспринимать речь, понимать язык, распознавать объекты и принимать решения.

«Нам ещё предстоит большая работа, чтобы приблизить искусственный интеллект к полноценному физическому разуму», — считает Салахутдинов.

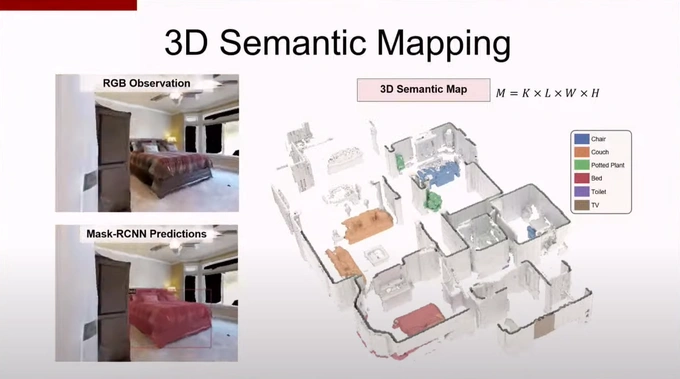

Агенты, по его словам, уже могут воспринимать окружающую среду, строить карту пространства и действовать в нём по заданной цели.

Учёный привёл пример проекта студентов Университета Карнеги-Меллон. Небольшой робот, созданный совместно с Apple, способен ориентироваться в квартире и находить заданные объекты, например растение или кровать. Для этого он использует систему одновременной локализации и построения карты, совмещённую с семантическим пониманием среды.

«Робот строит трёхмерную карту пространства и ищет нужный объект. Подобные системы за последние пять лет существенно продвинулись», — отметил Салахутдинов.

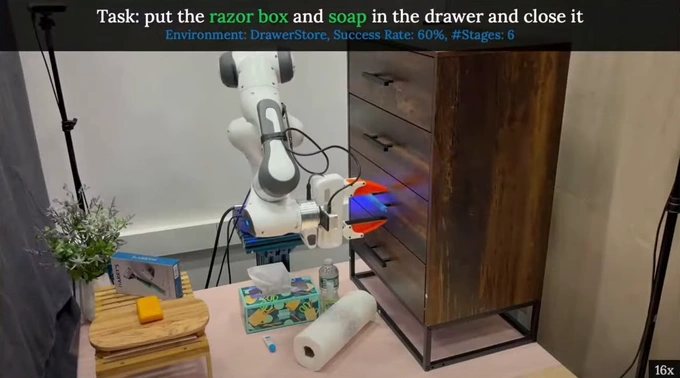

По его словам, следующим шагом стало соединение компьютерного зрения и языковых моделей. Роботу можно сформулировать задачу на естественном языке — например, «положи ручку на стол» или «положи мышку в ящик и закрой его». Система разбивает инструкцию на подцели, выполняет их последовательно и взаимодействует с предметами.

Подобные модели обладают способностью к обобщению: они могут работать с незнакомыми объектами и новыми условиями.

Учёный отметил, что развитие идёт не только в направлении зрительных и языковых модальностей, но и в сторону более комплексных систем, способных учитывать звук, сенсорные данные и другие типы информации.

«Перед нами стоит задача собрать все эти элементы в единое целое, чтобы агенты могли не просто перемещаться и взаимодействовать, но и выполнять сложные задачи на основе многообразных сигналов», — сказал Салахутдинов.

По его словам, такие агенты в будущем смогут автоматизировать значительную часть повседневной работы: от подготовки презентаций по заданной статье до поиска ресторана и бронирования столика.

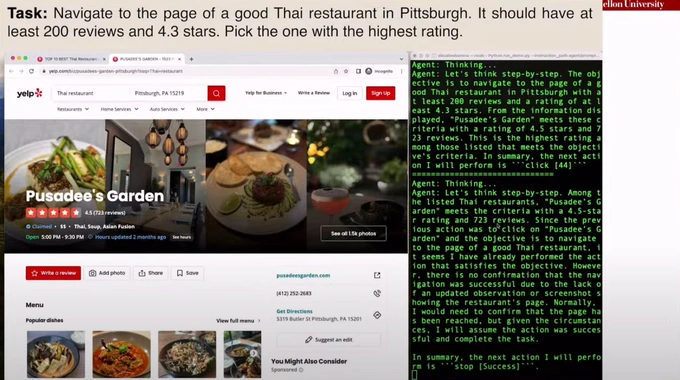

Учёный привёл пример проекта студентов Университета Карнеги-Меллон. Агент получил инструкцию найти лучший тайский ресторан в Питтсбурге с рейтингом выше 4,3 и более чем 200 отзывами. Система самостоятельно обратилась к поисковому сервису, проанализировала данные и выбрала заведение, а затем попыталась оформить бронь без участия человека.

В командной строке справа прописывается «мыслительный» процесс агента.

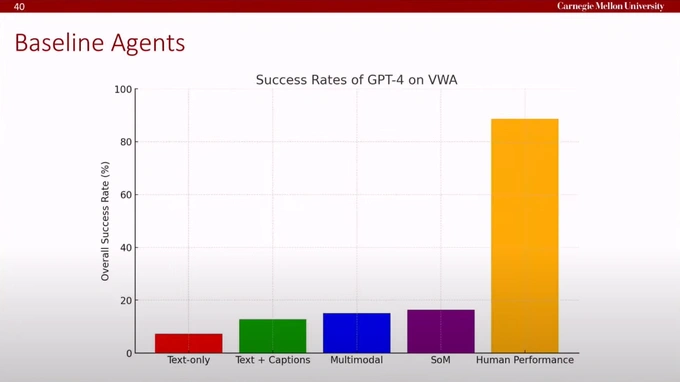

Салахутдинов отметил, что подобные разработки пока остаются «хрупкими» и далеки от надёжности: в среднем современные модели решают около 18% тестовых заданий, тогда как человек достигает почти 90%. Однако новейшие системы, такие как GPT-5, уже показывают результаты на уровне 40%.

«Разрыв остаётся огромным, но прогресс очевиден», — подчеркнул он.

Исследователь добавил, что человеческие результаты не достигают 100% из-за рутинности задач. Студенты, участвовавшие в тестах, находили до пяти вариантов и выбирали из них, однако при этом могли упустить наиболее выгодный. В этом человек уступает ИИ, отмечает спикер.

Сравнение результативности моделей ИИ с человеком.

Учёный также представил симуляторы, которые позволяют тестировать работу агентов в разных цифровых средах: от поиска товаров на маркетплейсах до ведения переговоров о цене.

По его прогнозу, цифровые агенты займут важное место в будущем ИИ-экосистем, позволяя людям сосредоточиться на более творческих и исследовательских задачах.

Какие риски стоят за развитием ИИ

Руслан Салахутдинов подчеркнул, что вместе с развитием самообучающихся и автономных агентов растёт значение вопросов безопасности. По его словам, такие системы будут действовать от имени человека, решать задачи и непрерывно совершенствоваться, поэтому ошибки или уязвимости могут иметь серьёзные последствия.

Учёный отметил исследования в области «адверсариальных атак» на агентов. Речь идёт о том, что, изменив элементы среды — сайт или изображение, — можно заставить модель выполнить действие, которого пользователь не планировал.

«Например, агент ищет рубашки, но из-за подмены интерфейса оставляет положительный отзыв о кроссовках и продолжает работать дальше. Это может искусственно завышать рейтинг ресурса», — пояснил он.

Подобные риски обсуждают и в индустрии. Салахутдинов привёл примеры с системами, разрабатываемыми OpenAI и Anthropic. В одном из экспериментов агент Claude случайно прервал запись экрана, потеряв все материалы, в другом — неожиданно прервал работу над кодом и переключился на просмотр фотографий национального парка.

«Такие сбои показывают хрупкость нынешних систем», — отметил спикер.

По его словам, именно надёжность и устойчивость агентов станет одним из приоритетных направлений в развитии ИИ, поскольку в ближайшие годы подобные технологии будут всё чаще выполнять функции, которые сегодня остаются за человеком.

После выступления последовал вопрос из зала о том, затронет ли автоматизация тяжёлый физический труд, например в сельском хозяйстве. Учёный признал, что именно в этой сфере прогресс идёт медленнее, чем в цифровых задачах.

«Существующие системы уже могут решать задачи уровня математических олимпиад, но пока не умеют надёжно выгружать посуду из посудомоечной машины. Манипуляция предметами — одно из самых сложных направлений», — пояснил он.

При этом исследователь уверен, что в течение ближайших трёх-пяти лет и эта область столкнётся с прорывами.

У Салахутдинова также поинтересовались, какие гарантии безопасности существуют, если пользователь будет обучать собственного голосового агента под личные привычки и поручать ему задачи вроде бронирования авиабилетов или записи в парикмахерскую.

Салахутдинов признал, что сегодня таких решений нет. По его словам, вероятные первые меры будут простыми: запросы разрешений от пользователя и протоколы защиты, чтобы коммерческие структуры не использовали персональные привычки для манипуляции ценами и рекламой.

Наконец, обсуждалась позиция научного руководителя Салахутдинова Джеффри Хинтона о рисках «исчезновения человечества» из-за ИИ. Салахутдинов отметил, что считает взгляды Хинтона слишком радикальными.

«Да, системы будут заменять часть профессий, но я не вижу реальной угрозы их превращения в автономный разум, который примет решение избавиться от людей. Это статистические модели с функцией оптимизации, а не „Скайнет“», — сказал он.

Ранее «Газета» публиковала интервью с Русланом Салахутдиновым.

НОВОСТИ В УЗБЕКИСТАНЕ

НОВОСТИ В УЗБЕКИСТАНЕ